Oggi parliamo di apprendimento, definito come le modifiche relativamente durature e stabili che avvengono a seguito di un’esperienza (di solito, ma non necessariamente, ripetuta nel tempo). Come avvengono queste modifiche, a livello cerebrale? Cosa succede nel dettaglio quando impariamo qualcosa di nuovo, dalle primissime parole balbettate da bambini a informazioni complesse come, per l’appunto, i dettagli del funzionamento del cervello? 🧠

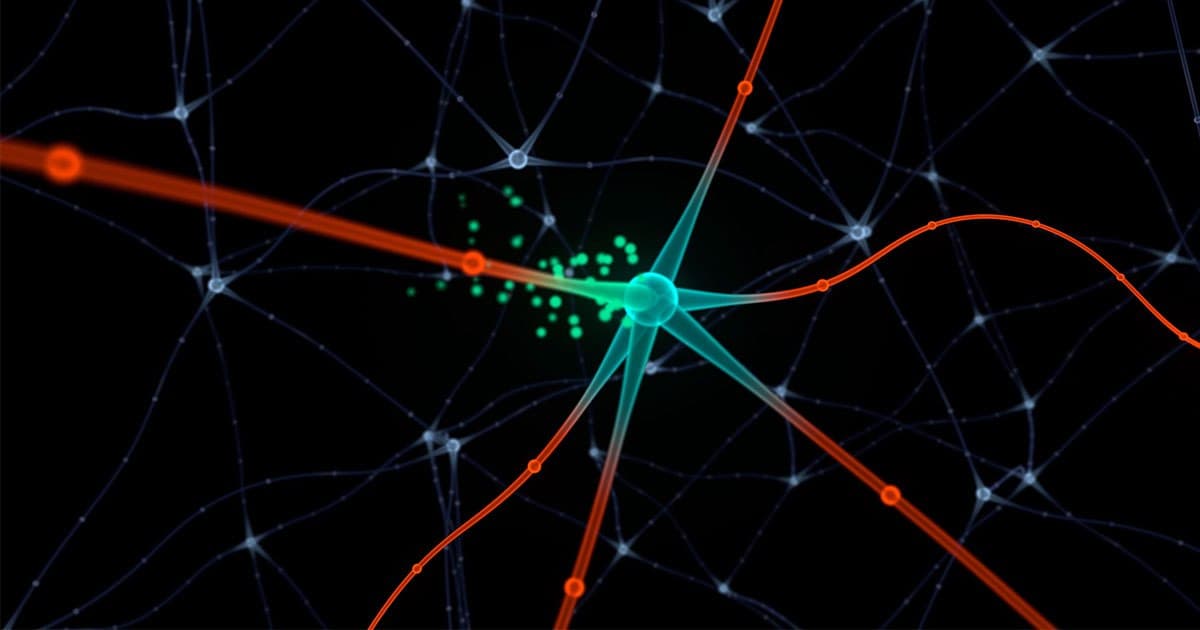

La regola che detta legge in proposito risale al 1949 e fu proposta dallo psicologo canadese Donald Hebb: i neuroni che scaricano insieme si connettono fra loro (in inglese suona come un vero e proprio slogan: neurons that fire together, wire together). In altri termini, se due (o due gruppi di) cellule nervose si attivano simultaneamente, allora, con il passare del tempo, l’attività di una causerà l’attività dell’altra. Di conseguenza, in parole molto povere, l’apprendimento avviene grazie alla formazione di nuove connessioni, durature, tra (gruppi di) neuroni – cambiamenti graduali che, nel loro insieme, costituiscono la cosiddetta plasticità cerebrale. ⚡️

Questa teoria connessionista dell’apprendimento influenzò, negli anni ’50 e ’60 del secolo scorso, lo studio delle reti neurali artificiali, alla base del machine learning (apprendimento automatico) oggi tanto in voga (qui ho spiegato un po’ di cosa si tratta). 💡

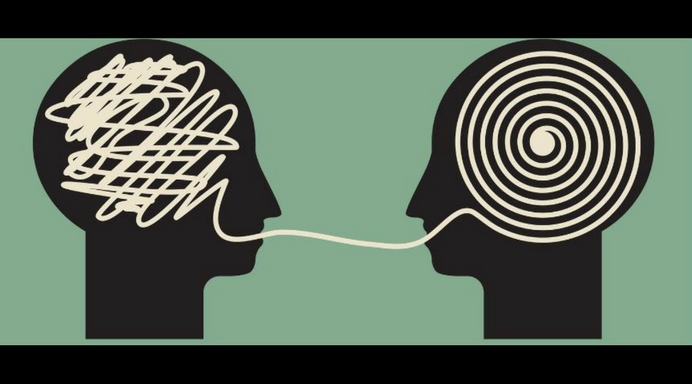

Ma i nostri cervelli imparano anche dagli errori, e le prime reti neurali non riuscivano a farlo. Fu necessario aspettare fino a metà degli anni ’80 l’avvento di un algoritmo che ne tenesse conto – l’algoritmo di backpropagation (retropropagazione). oggi molto diffuso per l’addestramento supervisionato di algoritmi di pattern recognition (per esempio, in un database di immagini, riconoscere quelle in cui ci sono dei gatti). 😺

Da allora, molti ricercatori si sono impegnati nella scoperta di un suo equivalente biologico, che però si è sempre rivelato elusivo – il backpropagation non è infatti compatibile con l’anatomia e la fisiologia cerebrale, in particolare con quelle della corteccia. Leggendo quest’articolo scritto da Anil Ananthaswamy per Quanta Magazine potrete scoprire a che punto siamo arrivati. 🔎

SapEvatelo

👉Perché queste ricerche sono importanti? A quanto ne sappiamo, non è detto che un algoritmo come quelli che conosciamo oggi sia la strada giusta per definire come funzionano i cervelli umani. E’ possibile – e per alcuni scienziati è una vera e propria certezza – che la metafora del cervello come computer ci porti completamente fuori strada, esattamente come quelle che l’hanno preceduta (macchina idraulica, orologio meccanico, telegrafo…). Ciononostante, è importante affrontare la questione dell’apprendimento da tanti punti di vista diversi, perché è proprio scoprendo sempre più cose su come funziona il cervello e come funzionano i suoi surrogati artificiali che, un giorno, potremo finalmente capire come si impara a imparare.